فایل robots.txt یک فایل متنی ساده است که در ریشه (root) اکثر وبسایتها قرار دارد. این فایل به موتورهای جستجو مانند گوگل، بینگ و یاندکس دستور میدهد که کدام قسمتهای وبسایت شما قابل ایندکس شدن و کدام قسمتها باید از ایندکس شدن جلوگیری کنند.

در واقع، این فایل یک توافقنامه بین وبسایت و موتورهای جستجو است که به موتورهای جستجو میگوید چه صفحاتی را میتوانند بخزند و چه صفحاتی را نباید بخزند.

چرا به فایل robots.txt نیاز داریم؟

حفاظت از محتوای حساس: با استفاده از این فایل میتوانید صفحاتی را که حاوی اطلاعات حساس یا محرمانه هستند، از دسترس موتورهای جستجو پنهان کنید.

جلوگیری از ایندکس شدن صفحات تکراری: اگر نسخههای مختلفی از یک صفحه در وبسایت شما وجود دارد، میتوانید با استفاده از فایل robots.txt از ایندکس شدن نسخههای تکراری جلوگیری کنید.

بهینه سازی خزش موتورهای جستجو: با مشخص کردن صفحاتی که برای موتورهای جستجو اهمیت کمتری دارند، میتوانید به موتورهای جستجو کمک کنید تا روی صفحاتی که برای شما مهمتر هستند تمرکز کنند.

حفاظت از منابع سرور: اگر وبسایت شما ترافیک بالایی دارد، میتوانید با محدود کردن دسترسی موتورهای جستجو به برخی قسمتهای وبسایت، بار سرور را کاهش دهید.

ساختار فایل robots.txt

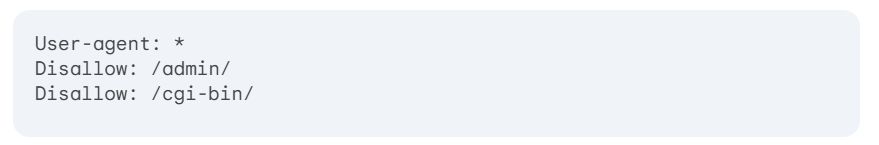

یک فایل robots.txt بسیار ساده است و از چند دستور ساده تشکیل شده است. دو دستور اصلی در این فایل عبارتند از:

User-agent: این دستور مشخص میکند که دستورالعملهای بعدی برای کدام موتور جستجو یا ربات وب است.

Disallow: این دستور مشخص میکند که کدام صفحات یا دایرکتوریها نباید ایندکس شوند.

در مثال بالا، دستور User-agent: * به این معنی است که دستورات بعدی برای همه موتورهای جستجو اعمال میشود. دستور Disallow: /admin/ به این معنی است که موتورهای جستجو نباید به دایرکتوری admin/ دسترسی پیدا کنند و دستور Disallow: /cgi-bin/ نیز به همین ترتیب برای دایرکتوری cgi-bin/ اعمال میشود.

سایر دستورات فایل robots.txt

علاوه بر دو دستور اصلی، دستورات دیگری نیز در فایل robots.txt وجود دارد که عبارتند از:

Allow: این دستور مشخص میکند که کدام صفحات یا دایرکتوریها میتوانند ایندکس شوند.

Sitemap: این دستور آدرس فایل sitemap.xml را مشخص میکند که حاوی اطلاعاتی در مورد ساختار وبسایت است.

Crawl-delay: این دستور به موتورهای جستجو میگوید که با چه فاصله زمانی صفحاتی را بخزند.

نکات مهم در مورد فایل robots.txt

فایل robots.txt الزامی نیست: هر وبسایت به فایل robots.txt نیاز ندارد. اگر فایل robots.txt وجود نداشته باشد، موتورهای جستجو میتوانند تمام صفحات وبسایت را بخزند.

فایل robots.txt یک دستورالعمل است، نه یک قانون: موتورهای جستجو موظف نیستند به دستورات فایل robots.txt عمل کنند.

فایل robots.txt یک ابزار قدرتمند است: با استفاده صحیح از این فایل، میتوانید به طور موثر کنترل کنید که موتورهای جستجو چگونه وبسایت شما را ایندکس میکنند.

نتیجهگیری

فایل robots.txt یک ابزار بسیار مفید برای وبمسترها است که به آنها اجازه میدهد تا کنترل بیشتری بر روی نحوه ایندکس شدن وبسایت خود توسط موتورهای جستجو داشته باشند.

با استفاده صحیح از این فایل، میتوانید به بهبود سئو وبسایت خود کمک کرده و تجربه کاربری بهتری را برای کاربران خود فراهم کنید.

توجه: برای اطلاعات بیشتر در مورد فایل robots.txt، میتوانید به مستندات رسمی موتورهای جستجو مراجعه کنید.